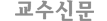

이미지로 당신의 삶이 예측된다면 어떨까. 지난달 23일 <MIT 테크놀로지 리뷰>는 ‘당신의 전자 장치가 사진을 통해 당신 삶을 예측하는 방법’이란 흥미로운 소식을 전했다. 특정 시간대 특정 이미지를 분석함으로써 미래를 예측할 수 있다는 것이다. 연구원들은 사진 이미지 목록을 통해 사용자의 평균적인 활동을 식별하는 인공신경망을 개발했다.

조지아공대 대학원생 다니엘 카스트로와 스티븐 힉슨이 이번 연구를 이끌었다. 연구원들은 사용자의 관점에서 가져온, 이른바 ‘자기중심적(카메라를 장착한 사람의 일상만 보여준다는 의미임)’ 장면을 인식하도록 설계된 인공신경망을 개발했다. 사진들은 보통 네러티브 클립, 미캠, 구글 글래스, 고프로와 같은 웨어러블 카메라에서 찍힌 것들이다. 핸드폰 사진도 종종 이용된다.

이 연구팀은 6개월이 넘는 기간 동안 한 명으로부터 약 4만개의 이미지들을 얻어 인공신경망 네트워크에 심었다. 사진을 제공한 지원자는 각각의 이미지가 어떤 활동과 연관되는지 수동으로 직접 분류하고 기록했다. 활동목록은 운전, TV 시청, 가족과 함께 보내는 시간, 위생 등을 포함한다.

신경망에 대한 이번 연구로 컴퓨터가 우리 일상 활동들을 더욱 정확히 식별할 것이다. 이번 연구를 통한 컴퓨터 모델은 이미지 분석으로 일상생활을 식별하는 데 약 83%의 정확도를 달성했다.

「기계학습 알고리즘을 이용한 비전 기반 자율학습 모바일 로봇」(최정민 대한기계학회, 2009)에 따르면 인공신경망은 인간의 뇌의 구조를 모방한 수학적 모델로서 패턴 인식과 데이터 마이닝, 제어 등의 분야에서 사용되는 인공지능 알고리즘이다. 특히 원본 데이터를 다양하게 가공하고 최적의 데이터를 인공신경망에 입력한다. 모든 데이터가 입력되지만 각 뉴런의 기여도를 파악해 영향이 적은 것들은 제거한다.

이번 연구에서 각각의 학습 알고리즘은 캡처된 이미지가 갖고 있는 메타정보(데이터베이스 시스템에서 데이터 관리상 필요한 작성자·목적·저장 장소 등 속성에 관한 데이터), 즉 날짜와 시간을 신경망 네트워크와 결합한다. 이에 따라 네트워크는 일상 행동들간 나타나는 공통된 연관성을 도출할 수 있다. 즉, 그 개인(전자장치 사용자)에게 다가올 스케줄을 예측할 수 있게 해주는 것이다. 연구자 힉슨은 “이러한 방식은 딥러닝과 일상의 기본적 맥락 정보를 연동시키는 것”이라고 설명했다.

연구결과는 일상 생활을 예견하고 학습하기 위한 최첨단의 딥러닝 기술의 이점을 보여준다. 딥러닝이란 사람과 같은 사고를 할 수 있는 인공지능(AI) 관련 기술이다. 영화 「Her」에서 컴퓨터 OS이지만 감정과 사고할 줄 아는 능력을 지닌 것으로 묘사된 ‘사만다’를 생각하면 된다.

기본 원리는 접하는 정보를 분류하고 입력된 알고리즘에 따라 작동하는 것이다. 딥러닝은 외부로부터 습득되는 정보를 처리하고 판단하도록 한다. 이 때문에 마치 판단하는 것처럼 보이는 컴퓨터나 인공지능이 인간과 같게 보이는 것이다. 분류는 나선형 신경망 네트워크(Convolutional Neural Network, CNN)를 사용한다. CNN은 기계학습에서 활용되는 소프트웨어로 인공 신경망 일종이다. CNN은 특히 수많은 데이터 내에서 선별적으로 패턴을 파악하도록 해준다.

입력된 사진과 일상생활 연관성 추적

웨어러블 기술개발자들은 이 기술로 더욱 통찰력 있는 서비스를 제공할 수 있다. 개발자들은 사용자의 식사나 운동 습관들 패턴을 분석하고 친절하게 안내를 해주는 어플을 상상한다.

그러한 전자 장치가 개발되면 당신의 스케줄을 학습해 그때그때 상황에 따른 똑똑한 제언을 받게 된다. 예를 들면, 교통정보 안내를 받고 평상시보다 일찍 출근할 수 있는 것이다. 연구원 카스트로는 “어플이 심지어 당신의 일상 행동을 재편성해줄지도 모른다”면서 “당신은 그런 정보를 훨씬 더 효율적으로 사용할 수 있다”고 말했다.

마이크로소프트 연구원 고든 벨은 ‘e-memory’를 연구해왔다. e-memory는 컴퓨터가 인간의 기억력에 도움을 준다. 벨에 따르면 핵심은 기계가 사진의 내용을 인지하도록 하는 것이다. 그는 “이번 연구결과는 좀더 일찍 상황 파악을 할 수 있게끔 하여 당신의 장기 기억 능력을 향상시켜주는 것으로 간주한다”며 “미래에 e-memory 알고리즘은 자기중심적 관점보다 더 많은 범위에서 사진을 넓고 다양하게 검색할 것”이라고 말했다.

다행히도, 이번 연구결과를 활용하고 싶은 사람들 모두가 4만 개 이미지의 데이터베이스를 갖추어야 하는 건 아니다. 2명의 지원자를 통해 이번 연구에서 적용된 기계-학습 ‘앙상블’을 테스트 했을 때, 생활 방식의 차이 때문에 많은 애를 먹었다. 힉슨은 지원자들이 컴퓨터 모델에 대한 미세한 튜닝(조정)이 불러오는 효과에 대해서 학습하고, 하루 동안 의미 있는 자기중심적 사진들을 가지고 교육을 받았다고 밝혔다. 그 결과 정확도는 매우 높아졌다.

그러나 웨어러블 카메라와 마찬가지로 사생활과 사용자 신뢰에 대한 복잡한 이슈가 있다. 사용자들의 사진은 해킹을 통한 범죄나 참견하기 좋아하는 광고 회사들에게 매우 좋은 타깃이다.

또한 경찰이 용의자를 추적하며 자동으로 기록하는 카메라를 사용하며 만연하게 된 정치적인 문제도 발생할 여지가 있다. 만약 소비자가 사용하게 될 장치에서 하드웨어가 강력한 기계 학습 알고리즘을 작동시켜야 한다면 문제는 다소 사그라들 수 있다. 데이터가 인터넷에 떠돌지 않게 한다면 말이다. 카스트로 연구원은 “보안 문제를 지금 인식하고 있다는 게 중요하다”며 “5년 내에 분명 상용화 하게 될 때까지 문제를 해결하면 된다”고 말했다.

연구원들은 자동으로 이미지를 식별하고 개인 정보를 제거할 수 있는 사진-분석 알고리즘의 가능성을 검토하고 있다. 이는 몇 년 전까지만 해도 큰 포부로 보였던 일이다. 기계-학습 커뮤니티가 도래한다면 매우 흔한 작업일지 모르지만 말이다.

김재호 학술객원기자 kimyital@empas.com

번역 제공

번역 제공